【摘要】對事效力是人工智能法的基礎性問題,人工智能法對事效力的框定,既關乎人工智能法學自主知識體系的構建,也為人工智能立法、執法、司法與守法提供關鍵指引。人工智能作為包含數據、網絡、算法、算力及具體應用的有機系統,構成對事效力的初次框定基礎,其調整范圍覆蓋全生命周期的涉數、涉網、涉算、涉用行為;人工智能法聚焦現行法律難以應對的社會損害救濟與預防,完成對事效力的二次框定;以 “負責任人工智能” 為理念欲求,將全生命周期利害關系人納入規制范疇,實現三次框定。經由調整客體、規范性質和理念欲求三種核心框定標準,人工智能法既區別于救濟個體私益的私法,也不同于其他救濟社會公益的公法,對推動人工智能法治體系完善具有重要理論與實踐價值。

【關鍵詞】人工智能法 對事效力 調整客體 規范性質 理念欲求

【中圖分類號】D99/TP18 【文獻標識碼】A

【DOI】10.16619/j.cnki.rmltxsqy.2026.01.010

【作者簡介】陳亮,西南政法大學人工智能法學院院長、教授、博士生導師。研究方向為人工智能法學基礎理論、算法規制,主要論文有《人工智能立法背景下人工智能的法律定義》《人工智能立法體系化的理論證成與路徑選擇》《算法驅動下平臺媒體監管范式的重構》等。

國務院于2017年7月印發的《新一代人工智能發展規劃》提出,自2020年至2030年的十年間,分三步構建完備的人工智能法律法規體系,為我國躋身世界主要人工智能創新中心提供堅實法治保障。當前,我國人工智能立法工作正穩步推進,既需統籌考慮國際競爭與合作的雙重態勢,也需深化理論研究以更好地對接實踐需求。而人工智能法的效力范圍,正是這一領域尚未形成廣泛共識、亟待學界充分關注與深入探討的重大理論問題。

人工智能法的效力范圍涵蓋對人效力、對事效力、時間效力與空間效力四大維度。其中,對事效力具有基礎性地位,在一定程度上影響乃至決定著其他三種效力范圍的邊界尺度。所謂對事效力,又稱事項效力,通常是指某一法律對特定主體的相關行為、事項及社會關系所具有的有效力,其核心問題指向是國家在與國民的關系中享有多大權限的問題。[1]當前,國內外關于人工智能法對事效力的研究成果尚不多見。據筆者梳理的資料,國內青年學者韓旭至曾從立法目的和基本范疇雙重視角,探討我國人工智能法的應然調整范圍,[2]國外學者約納斯·許特(Jonas Schuett)和漢娜·魯舍邁爾(Hannah Ruschemeier)則在批判單純以人工智能概念劃定人工智能法對事效力之缺陷的基礎上,提出以“風險類型”作為界定人工智能法事項效力范圍的主要依據。[3]本文認為,人工智能法對事效力范圍的界定,既取決于其調整客體——人工智能的內涵和外延,亦與人工智能法同其他法律部門的具體分工密切相關。因此,“調整客體”、“規范性質”和“理念欲求”應成為框定人工智能法對事效力的主要標準。

“調整客體”標準:第一性原理視域下人工智能法對事效力的初次框定

第一性原理(first principle thinking)思維是指通過將復雜問題分解為最基本的事實或假設,再以此為基礎重建思考的方法,其核心在于將特定事物解構為各種要素進行分析,進而找到實現特定目標的最優解。第一性原理是古希臘哲學家亞里士多德的哲學體系的核心概念,始終貫穿西方哲學發展歷程,并在科學、商業乃至法學等各個領域持續演化。第一性原理思維對于人工智能法對事效力范圍的框定具有重要方法論價值,這意味著人工智能法所追求的規制理念之實現,必然依托于人工智能的各構成要素,也依托于人工智能全生命周期中各利害關系人的具體行為。由此可見,人工智能的內涵界定在人工智能法律規制中具有前提性意義。[4]對人工智能概念進行“庖丁解牛”式的拆解,精準把握其具體構成要素,以及各要素在實現人工智能規制理念中的地位與作用,是框定人工智能法對事效力應然范圍的必然要求。

自1956年達特茅斯會議提出“人工智能”這一概念至今,其內涵與外延便成為學界熱議的焦點話題,甚至引發所謂“人工智能學術文章的惡性膨脹”現象。不同學科的學者基于各自的概念界定訴求,大致形成了三種表述各異、內涵不一的人工智能概念:技術專家立足人工智能研究需求,從“內部”視角將其界定為一門“科學”,旨在厘清人工智能學科的范圍邊界、長遠目標及實現該目標的具體路徑;社會技術專家則聚焦人工智能對現實世界的影響,從“外部”視角將其界定為包括開發者、維護者在內的“社會技術系統”,旨在解答人工智能核心要素(如算力、數據及勞動力等)的地緣政治學或政治經濟學意義,以及能力各異的人工智能如何催生各領域多樣化應用,進而塑造新的行為模式或社會影響;規制學界與規制機構以實現人工智能的科學規制為目標,將其視為法律規制的對象,借此明確法律法規與治理機制的具體適用范圍。這三種定義雖各有其合理性,卻均無法為人工智能法對事效力的具體框定提供有效指引。三種定義的共同問題在于,未能從技術架構視角界定人工智能的概念內涵與外延,而技術架構恰恰是所有人工智能法律法規必須聚焦的核心,更是法律根據不同參與者在人工智能技術管理中的地位與作用,為其配置相關權利義務的必然要求。

依據第一性原理思維,劃定人工智能法對事效力的最優路徑,在于精準錨定人工智能技術架構的核心要素。學界普遍認可,人工智能是連接數據、算法和算力的技術集合,數據、算力、算法是人工智能的三個核心要素,統稱為“人工智能三件套”(AI triad),三要素相互依存、相互影響、相互作用,共同決定著人工智能的性能水準。其中,數據被譽為人工智能的“石油”,是人工智能算法用于學習、適應和作出預測的原始素材,數據的質量、數量、多樣性及代表性等,直接影響人工智能系統的性能;算法被譽為人工智能的“大腦”,作為解決問題或完成任務的一系列指令,決定著機器如何從數據中學習、處理信息并作出決策,是調控人工智能系統行為的智能指令;算力則指大規模運行算法所需的軟硬件基礎設施。

事實上,“人工智能三件套”并未完全涵蓋決定人工智能性能的全部核心要素。人工智能并非單一技術,而是由多個相互關聯的工具組合而成的“工具箱”(toolbox)。這一“工具箱”屬于不斷擴展的開放系統,其內容包括但不限于數據、算法、算力、數字平臺乃至人工智能應用本身。鑒于“工具箱”內各工具之間的相互依存、影響與作用,對人工智能的規制或治理不能孤立聚焦其中某一個或某幾個要素,而應在厘清各要素間相互關系的基礎上,構建體系化的管控框架。

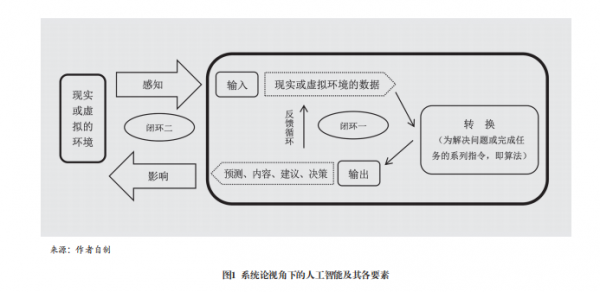

系統論思維為體系化處理“工具箱”內各要素的相互關系提供核心理論支撐。系統是指由相互作用、相互依賴的若干組成部分結合而成的有機整體,具有組件、流程、邊界、協同作用與反饋循環等特征,[5]而系統論思維則被描述為通過整體與關系而非拆分部分的方式,為復雜世界提供有意義解釋的視角、語言與工具,對于解決復雜問題、解釋非線性行為,以及厘清國家、組織與個人間看似不合邏輯的行為,具有非常重要的作用。[6]在系統論思維看來,人工智能可被描繪為包含輸入、轉換、輸出與反饋回路的系統,[7]其核心邏輯具體可通過圖形表示如下(見圖1)。

如圖表明,人工智能首先需從虛擬或現實環境中感知各類信息,這些信息以數據形式交由算法處理后,形成預測、內容、建議或決策等各類輸出,這些輸出要么作為反饋形成新數據,再次提交算法處理以進一步優化輸出(圖1閉環一),要么直接作用于虛擬或現實環境,其反饋結果將成為算法處理的新對象(圖1閉環二)。至此,我們可大致提煉出人工智能不可或缺的五個核心要素:數據、網絡、算法、算力及人工智能具體應用。其中,網絡源自現實或虛擬環境,既是人工智能訓練數據之源,也是人工智能影響現實環境的媒介,因而成為人工智能系統不可或缺的核心要素;數據被譽為人工智能的“血脈”,是算法學習、適應與預測的原始素材,更是人工智能處理信息、執行復雜任務的關鍵支撐,因而也是人工智能系統不可或缺的核心要素;算法作為人工智能的“大腦”,承載著完成特定任務必需的各類規則與指令,同樣不可或缺;算力指大規模運行人工智能算法所需的軟硬件設施,不僅決定算法處理數據的規模與效率,還影響人工智能模型的智能水平,因而成為人工智能規制與治理的重要對象;人工智能具體應用同樣源自虛擬或現實環境,在閉環二中發揮關鍵作用,通過反饋循環的方式影響甚至決定人工智能的性能表現。人工智能這五個核心要素,具有重要規制意義,有助于政策制定者明確管控各構成要素所需的各類監管手段與工具,最終保障規制目標的實現。

綜上,我們可將人工智能界定為包含數據、網絡、算法、算力及具體應用在內的有機系統,這五個要素是其不可或缺的核心組成部分,相互依存、影響與作用,共同決定人工智能模型的性能層級。因此,人工智能法不應僅關注人工智能的具體應用場景,而要將其視為一種動態復雜系統,進行體系化監管。[8]復雜性理論中的“蝴蝶效應”指出,非線性復雜動態系統對初始條件具有高度敏感依賴的特征,初始條件的任何微小變化,均可能引發截然不同、往往難以預測的長期結果。[9]因此,人工智能這一復雜系統的全部核心要素,均應納入人工智能法的調整范圍。申言之,人工智能法的對事效力,應大體框定在人工智能研發、部署與使用全生命周期中的涉數(數據)、涉網(網絡)、涉算(算力和算法)和涉用(人工智能具體應用)等具體行為。但需明確的是,并非所有此類行為均應由人工智能法調整,比如,侵犯個人隱私的涉數行為,本質上更適合交由民法(尤其是個人信息保護法)等私法規范調整。這意味著,除“調整客體”標準外,還需其他用以框定人工智能法對事效力范圍的標準。

“規范性質”標準:部門法分工視域下人工智能法對事效力的二次框定

一國調整其成員行為的法律規范浩如煙海、體系錯綜復雜,給法律的學習、研究、梳理和適用帶來困擾。自古羅馬時期至今,解決這一難題的常用辦法是:依據理念欲求、調整對象及規范性質等指標的相似程度,對本國全部法律規范進行分類或分組,進而劃分出理念各異、對象分殊、性質迥異的法律部門或法律領域,如公法與私法、實體法與程序法、國內法與國際法之分等。這種分類以體系化方式整合一國復雜的法律體系,厘清各種法律規則之間的相互關系及彼此影響,從而為法律的學習、遵守、適用乃至續造提供便利。

在眾多法律分類中,以填補損害或預防風險為核心目的,亦是一項重要的分類標準。填補損害、預防風險不僅是一國干預國民生活的正當性基礎,還決定著國家干預國民生活的具體法律方式與手段,甚至可能成為某一法律的核心概念。[10]因此,厘清人工智能領域的損害(風險)及其性質,是探討人工智能法規范性質的關鍵前提。

自約翰·斯圖亞特·密爾在其著作《論自由》中提出“損害原則”以來,學界對損害概念的界定從未停歇。[11]從最廣泛的意義上講,“損害”指對他人造成的任何不利后果,或是使特定主體境況惡化的任何情形,這意味著損害的認定,需以某種基準為參照進行比較。而比較基準的差異,決定了損害概念內涵與外延的不同:一是時間基準(temporal comparative account),即損害是指相較于行為或事件發生前,特定主體境況出現的所有惡化情形;二是人類福祉基準(mankind comparative account),即以人類平均福祉為比較基準,凡使特定主體的福祉低于人類平均福祉的情況,均可認定為損害;三是反事實基準(counterfactual comparative account),即若未發生某個事件或行為,特定主體的境況本會更好,這種“本可避免的惡化”即構成損害;四是道德原則基準(moralized harm principle),即強調造成損害的作為或不作為須具備道德可責性。[12]盡管這四種基準厘定的損害概念具有一定合理性,但仍無法為國家干預國民社會生活提供明確而具體的指引,既難以避免國家干預過寬或過窄的風險,也難以有效平衡個體自由與國家干預之間緊張而微妙的關系。

“損害”是密爾用以劃定個人自由邊界的基礎性概念,其內涵與外延本應是密爾討論的重點。遺憾的是,在密爾的《論自由》中,“損害”概念的內涵與外延并未得到系統、充分的討論,僅散見于書中某些段落的只言片語,既潛藏于損害概念與自由原則的關聯之中,也蘊含在密爾關于國家強制干預國民生活合法性的諸多論述里。從這些論述中,我們可大致梳理并推導出密爾“損害”概念的三個特征:一是涉他性,即損害是行為主體之外的其他人感知到的不利后果,包括個人、集體和作為整體的社會所感知到的不利后果。密爾指出,“一個人的行為的任何部分一到有害地影響到他人利益的時候,社會對它就有了裁判權”,而“當一個人的行為并不影響自己以外的任何人的利益,或者除非他們愿意就不需要影響到他們時(這里所說的有關的人都指成年并具有一定理解力的人),那就根本沒有蘊蓄任何這類問題之余地”,[13]這些表述充分證明密爾損害概念的“涉他性”特征。二是損益性,即損害是對他人利益的減損,會導致他人的需求無法通過相應客體得到滿足。密爾指出,“至于對他人有害的行動,那就需要有完全不同的對待了”。這里的“有害”,是指“侵蝕他人的權利,在自己的權力上沒有正當理由而橫加他人以損失或損害,以虛偽或兩面的手段對付他人,不公平地或者不厚道地以勢凌人,以至自私地不肯保護他人免于損害——所有這些都是道德譴責的對象,在嚴重的事情中也可成為道德報復或道德懲罰的對象”,[14]這意味著“減損他人利益”是密爾損害概念的又一重要特征。三是可責性,即減損他人利益的行為具有法律或道德上的可責性,應受到法律的懲處或道德譴責。密爾認為:“如果一個人的行為既沒有違反對于公眾的任何特定義務,也沒有對自己以外的任何個人發生什么覺察得到的傷害,而由這種行為產生出來對社會的損害也只屬非必然或者說是推定的性質,那么這一點點的不便利,是社會為著人類自由的更大利益之故事能夠承受的。”[15]可見,密爾的損害概念具有濃厚的規范意蘊,其是保障個體自由免受國家不當干預的“試金石”,也是平衡個體自由與國家干預的“壓艙石”,其相對嚴苛的內涵為最大限度保障國民個體自由提供支撐。

在損害概念的三個基本特征中,“涉他性”對確定損害救濟與預防相關法律規范的性質具有關鍵意義。這里的“他”既可能是個體或集體,也可能是不特定的社會公眾,而不同主體所受損害的救濟,往往分屬不同的法律部門或領域。若“他”為個體或集體,損害救濟通常歸屬于民法(調整平等主體之間的關系)或行政法(調整不平等主體之間的關系);若“他”為不特定社會公眾,損害救濟則可能歸屬于經濟法。人工智能全生命周期的各類要素及其模型應用所引發的損害,既包括個體損害、集體損害,也涵蓋社會損害。其中,針對個體損害與集體損害的救濟,現行法律法規或可直接適用,或經適度修正與調整后適用;但對于其中的社會損害,現行法律體系尚難以應對。有鑒于此,人工智能法應聚焦社會損害的救濟與預防。

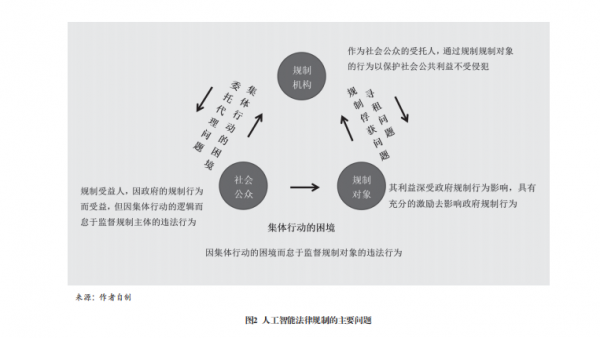

社會損害的救濟與預防面臨一大核心困境:作為受害人的社會公眾,因“理性經濟人”的本性,天然存在“搭便車”的傾向,由此造成社會損害救濟與預防中的“公地悲劇”;而作為公共利益受托人的一些地方政府,因與作為委托人的社會公眾存在目標函數差異,易出現逆向選擇、道德風險、規制俘獲、設租與尋租等損害委托人利益的現象。因此,解決人工智能全生命周期中因政府失靈與市場失靈導致的社會公共利益受損問題,應成為人工智能法的主要目標追求(見圖2),這也表明,人工智能法本質上屬于規制法的范疇。

“理念欲求”標準:部門法分工視域下人工智能法對事效力的三次框定

除了從受害主體視角劃分一國法律體系之外,理念欲求亦是區分不同法律部門的重要標準。舉例而言,同樣是私主體所遭受的人身或財產損害,若以保障受害人的意思自治為宗旨,則歸屬于以“私法自治”為理念欲求的民法范疇;若以防范行政機關的濫權或恣意行為為目標,則歸屬于以“控權”為理念欲求的行政法調整范疇。從這個意義上講,人工智能法的理念欲求,是框定人工智能法對事效力的另一重要標準。

法律理念是指法追求的價值目標或者關于法應該是什么樣的理想,是“法律的靈魂”,“代表了社會中公認的某種終極理想和價值”。[16]從這一維度而言,人工智能法的理念欲求,必然蘊含于人類關于技術倫理的持久探討之中,是對人工智能發展和治理倫理基礎的高度凝練與系統概括。

技術倫理是指導技術發展的道德原則總稱,其核心宗旨在于確保技術創新與發展能夠造福整個人類社會。對新興技術的倫理關切,始于21世紀早期,其開端為吉姆·穆爾(James Moor)于2005年發表的奠基性論文《我們為什么需要為新興技術提供更好的倫理學》。自此之后,原本分散、被動、方法論不成熟,且重點關注成熟技術且缺乏政策導向的倫理學研究,開始轉向更為聚焦、主動、方法論成熟,且重點關注新興技術注重政策導向的獨立研究領域,[17]而旨在確保技術發展契合社會期待與價值觀的“負責任創新”理念,也正是在這一過程中逐步被提出并得以固化。

從最廣泛的意義而言,“負責任創新”通常指以符合倫理、可持續理念及社會價值期待的方式,對新技術進行設計、部署與應用的具體實踐。學界將其描述為“一個透明的互動過程”,在此過程中,“社會參與者與創新者能夠相互響應,以關注創新過程及其產品在倫理可接受性、可持續性以及社會期待方面的表現”,其核心要義在于要求所有參與新技術開發的利益相關者,均需對其開發的技術承擔責任。

人工智能作為一項新興的顛覆性技術,理應遵循新興技術倫理的一致共識,而以人工智能為其規制對象的人工智能法,則肩負著將“負責任創新”內化為自身理念與制度內核的時代使命。有鑒于此,將“負責任人工智能”確立為人工智能法的理念欲求,正是“負責任創新”這一公認的技術倫理原則在人工智能法律規制領域的具體細化。所謂“發展負責任的人工智能”理念,是關于人工智能應如何研發、部署、使用、評估以及治理的提議或規范性聲明,[18]其由一系列確保人工智能透明、負責和合乎道德的基本原則所構成,旨在推動人工智能技術的應用與民眾的期望值、組織的價值觀及社會的法律規范相契合。[19]“發展負責任的人工智能”理念及其所蘊含的原則,涵蓋人工智能全生命周期所需的各項要求,能夠最大限度地預防或降低人工智能應用中的不利后果,因而受到世界各國的青睞,并被納入各國政策文件與立法規范,成為公共部門與私營企業必須遵守的行為準則。

“負責任人工智能”的理念,對人工智能全生命周期所有利害關系人均提出要求,進而具備框定人工智能法事項效力具體范圍的功能。該理念旨在推動社會參與者與創新者形成相互響應,進而使其創新過程及相關產品符合倫理準則、可持續性及社會期待。依據利害關系人理論,人工智能全生命周期的社會參與者,理應涵蓋保障人工智能實現負責任發展所需全部要素的相關參與者。如前文所述,構成人工智能系統的核心要素包括數據、網絡、算法和具體應用場景,這意味著人工智能全生命周期中的涉數主體、涉網主體、涉算主體及涉用主體,均屬于人工智能法事項效力中所指向的特定主體。

結語

科學框定人工智能法的對事效力,具有極為重要的理論和現實意義。從理論層面而言,這既是人工智能法區別于其他法律部門的重要標識,也是構建人工智能法學自主知識體系的關鍵依托。從實踐層面來看,其更是人工智能立法、執法、司法和守法的具體遵循,關乎人工智能立法效果的最終達成。在人工智能深度融入人類社會生活的當下,人工智能立法的緊迫性愈發凸顯,而對人工智能法對事效力的框定,則屬于人工智能立法的前提性問題,亟需學界緊扣人工智能法的理念欲求,結合人工智能法所欲救濟的損害類型與性質,準確且科學地框定人工智能法的對事效力,貢獻理論智慧、凝聚行業與社會共識。

注釋

[1]付子堂主編:《法理學初階》,北京:法律出版社,2009年,第144頁。

[2]韓旭至:《人工智能法的調整范圍》,《北京航空航天大學學報(社會科學版)》,2024年第3期。

[3]J. Schuett, "Defining the Scope of AI Regulations: Law," Innovation and Technology, 2023, 15(1); H. Ruschemeier, "AI as a Challenge for Legal Regulation: The Scope of Application of the Artificial Intelligence Act Proposal," ERA Forum, 2023, 23(3).

[4]在人工智能立法中,“人工智能”的概念界定同時具有三重功能:一是表達功能,也就是澄清人工智能法的立法意圖;二是劃界功能,即劃定人工智能法的事項效力;三是履行功能,即不僅是特定法律主體享有權利和承擔義務的依據,也是執法和司法解釋的重要依據。參見J. Schuett, "Defining the Scope of AI Regulations: Law," Innovation and Technology, 2023, 15(1)。

[5][7]M. S. S. EI Namaki, "A Systematic Approach to the Artificial Intelligence Concept," Journal of Knowledge Management Application and Practice, 2019, 1(2).

[6]I. Dula; T. Berberena; K. Keplinger and M. Wirzberger, "Hooked on Artifical Agents: A Systems Thinking Perspective," Frontiers in Behavioral Economics, 2023.

[8]Y. Arbel; M. Tokson and A. Lin,"Systemic Regulation of Artificial Intelligence," Arizona State Law Journal, 2024.

[9]E. Ferrara, "The Butterfly Effect in Artificial Intelligence System: Implications for AI Bias and Fairness," Machine Learning with Applications, 2024.

[10]A. C. Lin, "The Unifying Role of Harm in Environmental Law," Wisconsin Law Review, 2006.

[11]密爾在其著作《論自由》一書中提出“損害原則”,用以討論社會所能合法施于個人的權力的性質和限度。該書全部內容可以高度概括為兩個基本原則:一是個人的行為只要不涉及他人的利害,個人就有完全的行動自由,不必向社會負責;他人對于這個行為不得干涉,至多可以進行忠告、規勸或避而不理;二是只有當個人行為危害到他人利益時,個人才應當接受社會或法律的懲罰,社會只有在這個時候才對個人有裁判權,也才能對個人施加強制力量。參見約翰·密爾:《論自由》,許寶骙譯,北京:商務印書館,2007年,第112頁。

[12]A. Folland, "The Harm Principle and the Nature of Harm," Utilitas, 2022.

[13][14][15]約翰·密爾:《論自由》,許寶骙譯,北京:商務印書館,2007年,第90、93、98頁。

[16]鄭成良:《法律、契約與市場》,《吉林大學社會科學學報》,1994年第4期。

[17]P. A. E. Brey, "The Historical Development of Ethics of Emerging Technologies," Minds and Machines, 2025, 35(2).

[18]A. Theodorou and V. Dignum, "Towards Ethical and Social-Legal Governance in In AI," Nature Machine Intelligence, 2020, 2(1).

[19]P. Mikalef et al., "Thinking Responsibly about Responsible AI and 'the Dark Side of AI'," European Journal of Information Systems, 2022, 31(3).

The Theoretical Justification for Establishing Standards

of Effectiveness in AI Legislation

Chen Liang

Abstract: The scope of substantive effect constitutes a foundational core issue in AI law. Defining this scope not only concerns the construction of an autonomous knowledge system for AI jurisprudence but also provides critical guidance for AI legislation, law enforcement, adjudication, and compliance. As an organic system encompassing data, networks, algorithms, computing power, and specific applications, AI constitutes the foundational basis for the initial delineation of substantive effect. Its regulatory scope covers data-related, network-related, computation-related, and application-related behaviors throughout the entire lifecycle. AI law addresses social harm remediation and prevention beyond existing legal frameworks, achieving a secondary delineation of substantive effect. Guided by the principle of "Responsible AI," it incorporates stakeholders throughout the entire lifecycle into regulatory frameworks, realizing a tertiary delineation. Through three core delimitation criteria—regulatory objects, normative nature, and conceptual aspirations—the AI Law distinguishes itself from private law, which remedies individual private interests, and from public law that address social public interests. This approach holds significant theoretical and practical value for advancing the refinement of the AI legal system.

Keywords: artificial intelligence law, substantive effect, regulatory objects, normative nature, conceptual aspirations

責 編∕楊 柳 美 編∕周群英